在我多年的SEO顾问生中,我发现很多的客户都对XML 网站地图有较大的误解。不可置否,XML网站地图是一个强大的工具,但像其他此类工具一样,对这类工具的一些相关培训及工作背景知识的普及将是任重而道远的。

最常见的误解可能是,XML 网站地图可以帮助你的网页被索引,首先,我们要了解的是:谷歌不会因为你提出要求而索引你的页面。谷歌索引页面的要素有两个:一是他们发现并爬行了页面;二是他们认为页面质量达标而值得被索引。向谷歌指示出一个页面并要求其索引这个页面,从本质上来说并不意味着就能达成所愿。

话虽如此,向谷歌搜索控制台提交一个XML 网站地图仍然是很重要的一步,这意味着你想让谷歌知道在XML 网站地图上面的这些页面是高质量的搜索着陆页面,值得被索引。但是,这仅仅表明了这个页面的重要性,就像从你的主菜单链接到一个页面一样。

我在客户身上看到的最常见的误区之一是,针对于某一页面,向谷歌传递的信息不具有一致性。如果你在robots.txt里阻止了一个页面,同时又把这个页面放在XML网站地图上,那你就闹了个笑话。你的XML 网站地图会发出信号说“在这里!谷歌!这儿有一个十分有趣又高质量的精品网页你应该索引的”。然而你的robots.txt却早已把这个页面屏蔽了。meta robots也是一样的道理:不要在XML网站地图上出现一个页面后又设置一个"noindex,follow" 的metarobots标签。

说到这里,我就再简单说两句关于meta robots的问题,“noindex”表示禁止索引本页面。“Nofollow”则意味着“禁止追踪当前页面上设置的外出链接”就如把当前页面上链接能传递的权重都冲进厕所里。设置一个“noindex,nofollow”metarobots标签的原因多种多样,这里不能一一列举。只能说,如果你希望谷歌不去索引你的页面,你可以直接设置“noindex,follow”。

好啦,唠叨完了!

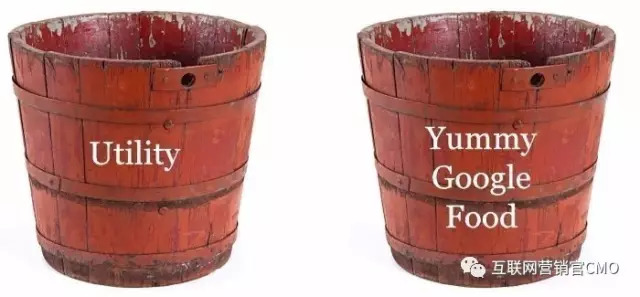

一般来说,你希望网站的每个页面都可以兼具下面两个木桶的功能:

在一号木桶里的页面,应是被robots.txt限定所禁止抓取的或者通过“noindex,follow”metarobots标签限制追踪的页面,都是不能出现在XML网站地图上的。

相反,在二号木桶的页面,应不受robots.txt访问限制,不应有“noindex” meta robots标签的禁止,并且很大程度上应该出现在XML网站地图上。

现在看来,谷歌正在针对体网站质量采取措施,用这个网站范围内的指标去影响搜索排名,而我这里说的并不是链接权重。

站在谷歌角度想一想这个问题。我们假设你拥有一个非常完善的页面,内容极好,从相关性到熊猫算法再到社交媒体的参与,可以说符合所有的标准。然而,如果谷歌发现你的网站1000多个页面的内容,只有5-6页是这样的精品内容。那么,如果谷歌把那些好的页面推送给用户的同时,用户也点击进入了其他不怎么样的页面,他们会有怎样一种体验?这样的机会肯定是有的,那时候他们登陆的就是一个垃圾页面,客户体验必定很差。谷歌又怎么会把那样的页面推送给客户呢?

谷歌工程师当然知道每个网站都会有一定数量的“实用程序页面”,他们对客户是有用的,但是却不一定是内容页面,而可能是搜索时的着陆页:内容分享、评论回复、用户登陆、密码找回等页面都属于这一类。

如果你的XML网站地图包含所有这些页面,那么你想向谷歌表达的是什么意思呢?或多或少,你还没搞明白哪些是构成你网站的好内容,哪些不是。

这是你想要展现给谷歌的一个图像。是的,我们有个1000页的网站,其中475页是高质量的网页。你可以忽略其余的页面,因为他们是实用程序页面。

现在,我们说谷歌抓取了那475个页面,根据他们的权衡,得出结论是当中的175个页面分数得“A”,200个得“B+”,100个得“B”或“B-”.那么这个整体的平均分就是很不错的,很有可能被定为十分优秀的网站而推送给用户。

相反地,一个通过XML网站地图提交的1000页的网站。现在,谷歌审核这1000个你说内容质量高的页面,但是发现超过50%的评分都是“D”或“F”,平均下来,你的网站就是一个劣等的网站;谷歌通常是不会把那样的网站推荐给用户的。

切记,谷歌会通过你提交的XML网站地图作为线索去找到你网站的重要内容。但是谷歌也不会因为有些网页没有囊括在XML网站地图中而忽略这些页面。你仍然还有很多的页面,在内容和链接方面做得不足,它们的收录并不能带来正面影响。

做一个网站,很重要的是:搜索你网站中被谷歌索引的所有网页,查漏补缺,清理那些被谷歌认为是低分的页面,将之设置“noindex,follow”标签(或者被封存在robots.txt里面)。通常,那些最差的但是仍被索引的网页,将会被排到一个网站的最末尾的位置:搜索。

用metarobots标签和用robots.txt来阻止一个页面被索引有一个重要而细微的区别,用meta robots标签“noindex,follow”允许链接传递到这个页面,并且再传递到这个页面所链接的其他页面。而如果你用robots.txt标签阻止页面抓取,那就等于你把它冲进厕所了。

以上的例子中,我拦截的那些不是真实的页面,那些是跟踪脚本,所以我没有失去链接权重,因为这些页面没有具备菜单链接等功能的页眉。

你会在什么情况下使用robots.txt协议?也许是当你有抓取带宽的问题和谷歌机器人花费大量时间提取实用程序页面,但只发“noindex,follow”标签并必须跳出的时候。当你观察到谷歌机器人出现没能到达你重要页面的情况时,你必须通过robots.txt协议阻止访问。

我看到很多客户通过清理他们的XML网站地图和禁止索引实用程序网页获得了搜索排名的提升。

我真的每天有6000到20000个页面需要被抓取吗?或者谷歌机器人会追踪”回复评论”或者”通过邮件分享”的URLs?

供你参考,如果你的页面有一个核心集,而且其内容都是有规律变更的(像博客,新产品,或者产品类目页面),或者你有许许多多的页面(像独立产品页面),如果质量好,谷歌便会索引他们,反之,则会面临不再重新抓取和索引核心页面的情况,你可以在XML网站地图上提交核心页面,给谷歌一个线索,这些应是你认为比其他没被阻止但不在网站地图上的网页更加重要的网页。

这就是XML网站地图对SEO有用的地方:当你提交一批页面给谷歌索引,但是只有一部分被索引。谷歌搜索工具不会告诉你他们索引了哪些页面,就只有一个XML网站地图总体被索引的数据。

我们假设你是一个电商网站,而且你有100000产品页面,5000个类目,20000个子类目页面。你在XML网站地图里提交了125000个页面,你发现谷歌索引了其中的87000个,但具体是哪87000个呢?

首先,你的类目和子类目页面对你来说有可能都是重要的搜索目标。我会创建一个category-sitemap.xml(总类目地图网站)和subcategory-sitemap.xml(子类目地图网站)并分别提交。你将会看到近100%的索引率。如果你没有做到,那你就应该知道要去关注怎么为页面创建更多内容或者为他们增加链接权重,或者两者兼备。你会发现像产品类目或者子类目页面,没有被索引是因为他们只有一个产品(或者没有产品)。这种情况下,你可能会希望在页面里面设置“noindex,follow”标签把他们从XML网站地图择回来。

问题就有可能出在这100000个产品页面里面,但具体是哪些呢??

先定一个假设,并把产品页面分割成不同的XML网站地图去检测那些假设。你可以同时做若干组的试验,一个URL同时出现在多个网站地图上面是没有问题的。

你可以从以下3个理论着手:

创建一个XML网站地图,用一系列具备实际意义的页面,并分别将这些页面归到不同的类目。不需要把所有的页面分配到类目,只要样本大小合理,足够让他们被索引即可。比如,你可以每个类目做100个页面。

在这里,你的目标是,对任意一个给定的网站地图,用整体的索引百分比分析,去判断页面被收录或者没被收录的因素。

当你知道问题所在,你可以修改你的页面内容(或者指向页面的链接)或者禁止索引页面。例如,在你的100000个产品页面中,可能有20000个页面的产品描述是少于50个词的。如果这些不是高流量的词,而你又是从制造商方面找到了产品描述,可能这不值得你去尝试手动为那20000个产品页面写200字的描述。你可能要为这些少于50字产品描述页面设置“noindex,follow”标签,因为谷歌无论如何也不会索引它们,而它们也只会拉低你整体的网站质量排名。同时,你也别忘记把这些网页清理出你的XML网站地图。

现在,你想“非常好,Michael。但现在我要手动操作来保持我所有的100000页面的XML网站地图和meta robots同步”这是不可能做到的!

但是,也的确没有必要手动去做这些。XML网站地图不能成为静态文件。实际上,他们甚至不需要有XML扩展去提交他们到谷歌站长工具。

相反,给页面设置规则逻辑,不管页面有没有包含在XML网站地图内,同时,用同样的逻辑在整个页面本身去设置meta robots标签索引或者不索引。如此一来,当制造商提供的产品描述从42个字变成215个字时,你网站的这个页面就会神奇地出现在XML网站地图上,并且让meta robots标签设置成“index,follow”。?

在我的旅游网站,我会对一系列的不同的页面做以上的工作。我会对那些页面使用传统的ASP。

当这些网站地图被抓取时,服务器密码会输出XML,而不是渲染一个HTML页面。这会从其中一个数据库表格中迭代一组记录,并根据特定的标准,分别输出一个数据。

那么那些让人头疼的视频XML网站地图呢?他们也太落伍了吧!Wistia根本不屑于再生产他们了,你大可以用用 JSON-LD 并用schema.org/VideoObject 在页面中做标记。

内容来源:互联网营销官CMO公众号,已获得公众号允许